降低数据中心耗能关键点:气流组织学问大运营维护

赤日炎炎似火烧,CIO心里半枯焦。时值盛夏,不断传来有单位机房因设备过热而宕机的消息。

北京网通数据中心檀君普对本报记者透露,在北京的绝大部分机房,电力部门的供电都不足。北京网通的皂君庙机房,就因为供电不足的问题,不仅无法扩容,而且现有出租机架获得的绝大部分费用都用来付了电费。

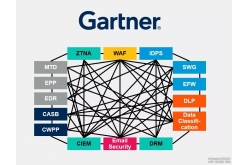

其实,从全球来看,数据中心都面临供电不足和电费高昂的问题。据Gartner预测,至 2008 年年底,全球近一半的数据中心将无法拥有足够的能源和冷却装置用以支持高密度的服务器和存储设备。而到 2011 年,数据中心三分之一以上的预算将分配给环境成本。

针对这样严峻的形势,数据中心节能成为摆在企业CIO面前的一道难题。

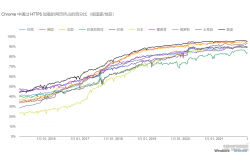

事实上,数据中心的节能应分为两大块:IT设备的节能和机房设施的节能。机房专家、《机房技术与管理》主编沈卫东表示,在国际上有一个通行的指标来衡量数据中心的电力使用效率——PUE(Power Usage Effectiveness),PUE=数据中心总耗能/IT设备耗能。国外先进的机房PUE值可以达到1.7,而我们国家的PUE平均值则在2.5以上,这意味着IT设备每耗一度电,就有多达1.5度的电被机房设施消耗掉了。因此,通过降低机房设施能源消耗达到节能的效果既现实又有效。

但许多人可能并不知道,漂亮的玻璃幕墙、宽敞明亮的机房、不当的机柜摆放方式都可能成为数据中心节能的“杀手”。那么,让我们暂时抛开服务器、存储等IT设备,重点来看一看机房设计及设施中影响节能的四大关键因素。

关键因素之一: 机房不应金玉其外

您是否看到过这样的数据中心机房:玻璃幕外墙、朝南、带明窗,内部既宽敞又明亮,但这样的机房在降低外界热辐射和热渗透方面的效率非常之低,应该算做不合格机房。如果您深入到机房内部,可能还会发现更大的问题:有的区域设备密度极大,原先的空调、UPS面临超载,急需添置新设施;有的区域设备密度则很小,空调、UPS的负荷又严重不足。甚至还有这样的情况:有的区域空调在制冷,有的区域空调在制热。

美国Osram Sylvania 公司的IT 运营经理丹·威尔逊发现,公司一个2000 平方英尺的数据中心正好位于工厂的装货平台,装货平台车辆进进出出,平台的门也开开合合,结果数据中心内空调系统的作用基本丧失。不仅如此,阳光还直射到数据中心外墙和屋顶。而且在设计数据中心时,公司还将一排排的服务器放在与空调装置平行的位置,结果使空调的效率大打折扣。用威尔逊的话说:“我们设计数据中心时只考虑了美观。”

对此,APC华北区系统工程部经理裘明说,数据中心机房的选址一定要合理,应该选朝北的房间,房间密封并且不设明窗,以降低外界的热辐射和热渗透。

此外,机房是不是越大越好?非也!威图IT产品经理韩勇表示:“机房越大,所消耗的能源越多,因此,用户在规划机房时需要改变越大越好的观念。通过增加IT设备安装密度、减小机房规模可以有效降低能源消耗。”

其实,无论是规划还是设计,节能问题都需要预先考虑。比如,如何平衡冗余度和可用性之间的关系就是数据中心建设一开始要考虑的问题。前期过度追求可用性必然导致设备采购和后期能源方面的浪费。所以,裘明表示:“用户一定要预先做好规划、找到合理的平衡点”。

导致数据中心高耗能的另一个因素是设计建设中没有采取分步实施的策略。裘明说,许多数据中心在设计建造时都想一步到位,这样不仅导致采购UPS和空调等设备时浪费投资,还提高了后期能源消耗和服务成本。“正确的做法应该是根据未来的需求设计几个台阶,分阶段采购所需的机房设施。”

绿色杀手:机房坐北朝南、开明窗、外墙不隔热、不密封、内部布局不合理、冗余度过高、建设求大求全。

关键因素之二:气流组织学问大

机房管理人员经常发现:空调日夜不停地转,可机房内的温度就是降不下来。怎么办?买更大的空调吗?机房专家此时会告诉你:这一决策往往是错的!因为机房达不到需要的温度往往都是由气流组织设计不合理引起的。

气流组织的目的是把空调产生的冷量送到IT设备端,并让IT设备产生的热气回到空调机。但气流的配送过程比电流要复杂得多,不好约束。

据沈卫东介绍,气流组织与现场情况密切相关,地板出风口的位置、尺寸大小、地板高度、地板下线缆线槽的密集程度、机柜高度、天花板高度等因素都会影响气流的输送。这样,就需要在合理设计中下功夫。比如让地板有足够的高度,以减少送风过程中的阻力,保持静压;减少线槽或改从天花板走线以减小冷空气在地下流动中的阻力;出风口的位置和大小根据机柜的冷量需要配置等等。

影响气流的另一个关键因素是机柜排放方式和摆放位置。比如,如果机柜一排排同向摆放,前面服务器排出热气被后排服务器吸收,冷热气流混合无疑会使空调制冷效率降低。沈卫东表示,机柜合理的摆放方式应是“面对面、背靠背”,以形成冷热通道,减少冷热空气混合。同时,如果出风口离空调机太近,空气的动压很大,静压很小,将会导致冷空气出不来。因此,当机柜离空调太近时不宜开出风口;而出风口离空调机太远,则冷风送不到,所以,机柜与空调的距离(送风距离)应在15米之内。

裘明则介绍了另一个控制机房气流的妙招:“在机柜没装设备的地方装上盲板,防止冷空气从空隙中流过,从而让冷空气只能通过服务器等IT设备,这样可大大提高制冷效率。”

根据美国一个数据中心改造的案例,通过对气流组织以及空调系统的改造,可以使机房PUE值从2.5降低到2.0左右,其效果不可谓不大。

绿色杀手:地板高度太低、地板下线槽多、出风口离空调太远或太近、机柜同向摆放导致冷热气流混合、机柜之间或内部空隙过大。

关键因素之三:新型空调好处多

如果您留意一下,常用的家用电器中当属空调的耗电最大,机房也不例外。如果数据中心电力消耗为100%,IT设备的消耗占30%,UPS的损耗在百分之十几,空调的耗电则在40%以上,可见空调是机房中的耗电大户。因此,如何让空调省电就是个大问题。

由于传统机房中空调送出的冷量不能百分之百送到服务器端,所以很大一部分都浪费掉了, “有时用户机房中UPS才80kVA,空调却要配到150 kVA!”裘明说,“ 大部分机房空调的效率也就在50%左右。”

要想使空调节能,一方面需要做好气流组织设计,另一方面可以选择新型的空调。据裘明介绍,APC的InfraStruXure InRow制冷单元可放在服务器机柜边上,让冷热空气直接在机柜和空调之间以最短的路径循环。当然,空调设备的成本会因此增高。但据裘明表示,通常在1~2年内可通过电费节省来收回。

韩勇同样推荐了称为液体冷却系统的水冷式空调。他说:“通过使用放在机柜旁侧的液体冷却系统,可以提高20%的电力使用效率。”

在国外,有更让人拍案叫绝的案例。美国365 Main 公司在加州纽华克市建造了美国国内第一个通过 LEED(杰出能源与环保设计)认证的数据中心。该数据中心机房空调的能耗不仅要比传统机房空气处理器的能耗少 30%,并且还可以使用外部冷空气进行制冷。

沈卫东在德国也曾看到过类似经过巧妙设计的空调。在他参观过的一个200千瓦的机房里,当室外温度低于10度时,用空气对空调机冷冻水冷却,然后对机房制冷,并把机房产生的热量收集起来传给办公楼的取暖设备,这样,整个数据中心办公大楼的能源费用可节约1/3.

绿色杀手:空调功率超过实际需求、传统空调不能针对局部热点降温、不能利用室外冷空气降温。

关键因素之四:巧用UPS和机房监控设施

购买UPS时,一般厂家都会告诉您:UPS的效率可达90%以上。可您是否知道:这一效率是建立在满载基础上的!实际应用中,在许多数据中心里 UPS的运行负载率一般也就在30%左右。那么,此时UPS的供电效率能达到多少呢?答案是:50%~60%.也就是说,经过UPS的电能有近一半被浪费掉了!

要想提高UPS的供电效率,沈卫东认为有两个办法,“一个是要求UPS厂商改进设计,提高低负载率下的UPS供电效率,另一个比较实际的办法是购买模块化设计的UPS,机房早期建设时少买少安装一些模块,等到添加新IT设备时,再不断增加UPS模块,以始终保持较高的UPS负载率。”

裘明对此表示赞同。他告诉记者,目前的技术已能够让UPS效率整体往前提,也就是在低负载率下具有高效率。比如,一些新型大功率UPS产品已经能够做到在负载率35%~40%之间时效率达到80%以上。他也特别强调了采用模块化产品对节能具有重要意义。

此外,通过使用机房监控设施、精确了解机房的电流、温度、湿度来控制空调、UPS等设备的运行,也能对节能起到重要作用。

对机柜环境的实时检测可以带来如何节能的参考依据。比如,机柜需要的冷量和通过的电流成正比,使用带电流显示的PDU之后,可以根据电流大小来调节出风口的大小,以达到节能效果。

“没有数据就没有管理。”机房监控设施正是通过把机房管理引向精确化从而让数据中心的颜色变得更绿。

绿色杀手:UPS功率过大、负载率太低、非模块化,缺乏监控设施、缺乏机柜电流、温湿度等具体数据导致管理失效。